从TP官方网址那儿去下载数据,此乃信息整合工作开始的地方,正确地把源头数据给获取到,能够保证后续分析具有准确性以及可靠性。官方渠道所提供的数据,一般来讲是最为权威、最为及时的,规避了二手数据有可能存在的偏差与滞后方面的问题。

在从TP官方网站开展下载操作之际,首屈一指的步骤乃是慎重地确认网址的精确性,千般小心地防止访问到冒牌站点。于着手下载以前,要细致地研读数据说明文档,深度地了解其中所包含的数据格式、更新频率以及字段含义这般关键的信息。

与此同时,提议搭建一套标准的下载程序,该程序要包含时间踪迹记录、版本管控以及原始文件备份等范畴,借由这些来为后续的数据整合事宜夯实稳固根基。

下载得来的数据通常得历经清洗与转换这两个环节才能够投入使用,我会首先把不同时期的数据按照统一格式去加以整理,认真地去除其中的重复记录以及无效记录,之后根据分析需求构建关键字段的映射关系,比如把那些有着不一样命名方式的字段进行统一,借此确保数据能够达成正确的关联与比对。

上面那些操作完成之后,还要进一步去检查数据的准确性,以及完整性。数据里要是有模糊或者不确定的值,得去核实,还要修正。与此同时,要把数据分类,并且归档,这样方便后续去查找,以及使用。经过这些细致的工作,使得数据达到更高的质量标准,给后续深入分析提供坚实可靠的基础。

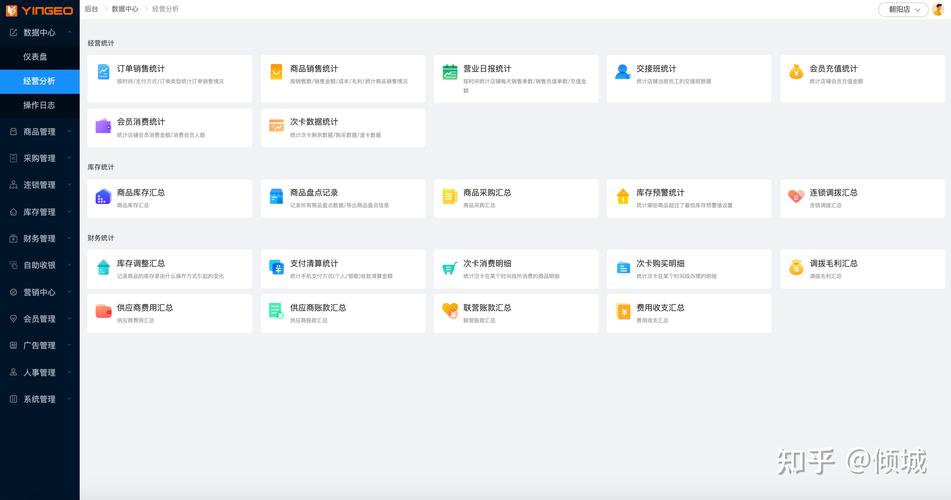

体现于实际业务里的是整合后的信息价值,比如说,整合多个时期的销售数据后,趋势变化能够清晰显现观看到;关联用户行为数据与交易数据,更深层的业务洞察就能够被发现寻觅到,这些整合工作给决策提供了扎实的数据基础。

你于信息整合进程里碰到过哪些下载或者处理数据的困难之处?欢迎去分享你的经验以及解决办法。