对TP官方网站开展数据提取工作,关键之处在于领会网站数据呈现逻辑以及掌握正确技术手段。不管是进行市场分析,还是从事价格监控,又或是开展学术研究,一般而言,直接复制粘贴这种方式效率很低且不准确,所以我们得借助更为专业的方法。

你得明确自身的数据需求,接着去检查网站自身是不是提供官方接口。多数专业网站,像TP这样的,请注意,它会提供API或者允许导出的CSV、Excel文件。你要登录自己的账户,在“报告”、“数据服务”或者“开发者选项”里找寻相关入口,这可是最稳定、合规的数据获取方式,能防止被网站封锁。

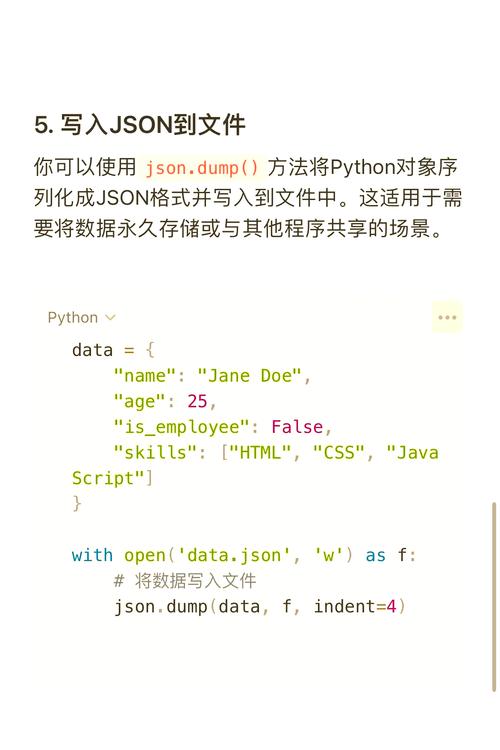

要是官方途径没法达成你的需要,那就再思索借助编写代码去模拟浏览器举动来获取数据。就拿Python来说,你能够运用requests库抓取页面原始代码,而后用BeautifulSoup解析HTML表格。可是要留意,针对于动态加载的内容,你或许得运用像Selenium这般的工具,并且去设置恰当的请求头以及访问频率,以此来模拟真实的用户,防止对服务器形成压力。

在开展数据抓取工作期间,一定要严格依循网站的robots.txt协议以及相关的法律法规。当着手处理提取得来的数据之际,要记住进行清洗以及结构化操作,就好象运用Pandas库把杂乱无章的数据整合成干净整洁的表格那样。如此一来,你才能够把原始数据转变为切实具备价值的商业洞察或者研究素材。

曾经,你于提取数据之际,所碰到的最为棘手的反爬机制究竟是什么呢?欢迎于评论区去分享你的经验,而后我们一同去探讨解决方案。